近年来,在各领域广泛落地的人工智能凭借在诸多传统复杂问题中的优越表现已获广泛认可,但如何确保以非技术性的方式,向用户解释算法决策原理以及驱动这些决策的数据,仍然是一个难以解决的难题。

“AI的应用落地在不断提速,但算法‘黑箱’下,AI的不可解释性让‘黑箱’难以释明,进而让人类对AI的安全难言放心。”日前,在2022年科技向善创新周上,与会专家围绕AI的透明和可解释难题从技术角度直指产业痛点。与此同时,由腾讯研究院、优图实验室等多家机构组成的跨学科研究团队历时一年完成的《可解释AI发展报告2022》也引发热议。报告从可解释AI的概念、监管趋势、行业实践、发展建议等热点问题出发,抽丝剥茧般地呈现可解释AI产业的现状和发展趋势,以期能为产业解决AI“黑箱”释明难题提供一份参考和借鉴。

可解释AI已成热点

人工智能已经成为通用型的技术,而人类对AI则一直有更高的期待。不少人坚信,科幻电影《Her》中的AI机器人可对行为做出解释,从而帮助人类做出决策,甚至与人类产生深度交流的一幕,迟早也会出现在人们的日常生活之中。

当然,这些过于理想化的场景目前还只能存在于科幻作品中,实践中的可解释AI不论在技术上还是在体验上都还没达标,但产业的发展已经起步并快速成为行业热点。

如今,金融机构的贷款审批都是基于AI作出决策,如果这一复杂的算法风控系统拒绝申请,那么贷款人就没办法获得贷款。这只是AI在众多日常场景应用中的一幕,只要是AI做出了决策,公众就必须接受结果,至于什么原因,算法没有也不可能给出解释。

“AI的算法‘黑箱’,有时候甚至连开发人员都不能很好地去理解算法运作的具体细节,这就导致了AI模型的透明度和可解释性的问题。”腾讯研究院秘书长张钦坤表示,如果不解决这两个问题,不仅影响用户对AI应用的信任,而且也可能会带来算法歧视、算法安全和算法责任等方面的相关问题。

其实,人工智能的可解释以及科技伦理等问题已经成为AI领域的必选项,2021年的“十四五”规划里面也明确强调要健全科技伦理的体系。

刚刚过去的2021年,则已被业内专家公认为是AI的可解释元年,而不仅仅是在学界,产业界也在积极探索让AI更加透明、可解释。国外主流的科技公司很早就成立了自己内部的科技伦理委员会,同时还在积极研发相关的技术解决方案。国内的互联网企业也开始采取类似的做法,如美团两次发文阐释外卖配送的相关规则,微博也公开了的热搜算法规则等。

厦门大学人文学院院长朱菁认为,AI可解释性问题之所以受到重视,主要因为AI的发展虽然变得越来越强大,但也变得越来越“黑”,再者AI虽然变得越来越实用,其可靠性和应用范围也得到提高。“在一些重要的应用领域,对于AI可信任性、安全性等方面的要求也越来越高,可解释性就是满足上述要求的认知基础。”

目前来看,国内企业在可解释AI实践方面还比较零碎,没有达到系统化的程度,但就整体而言,产业一直都是朝着可解释的方向有发展。

鱼和熊掌不可兼得

AI快速深入日常生活,既带来了兴奋和期待,也带来一些忧虑,甚至是恐慌。AI到底是人类的好帮手,还是会成为人类强劲的对手?其实这很大程度上取决于人类对AI的理解。

基于当前AI的可解释和透明度,人类并没有对AI做到完全的信任,但对于AI及算法带来的高效率依然无比推崇。显然,AI的可解释性及透明度与算法的高效率原本就是一个矛盾体。

微众银行首席人工智能官杨强认为,往往AI算法高效率的同时,它的可解释性就很差。同样,AI线性模型的准确率没有那么高,它的可解释性相对就会强一些。“这就意味着我们得在可解释和高效率两个维度上做一个取舍。虽然AI的迭代更新是在朝这个方向努力,但目前并没有在两个维度都高的AI算法。目前可解释AI在各个行业都是一个起步,也都不可或缺,但如何做好AI可解释的量化,才是当前业界该考虑的重点。”

“不同人群、不同应用场景对AI算法的可解释性期待是不一样的,不应该搞一刀切,也不应该用一个统一标准适用于所有情况。现阶段深度学习普遍缺乏可解释性的情况下,AI透明度就尤其重要。”腾讯天衍实验室负责人郑冶枫表示,AI算法应尽可能详尽地披露模型、训练数据分布等情况。“在不可能做到全部可解释的情况下,至少要让人们觉得AI是可视和可了解的。”

朱菁也认为,目前来说AI的可解释性和预测的准确性二者不可兼得,这是一个客观存在的状况。既提高预测准确性,同时还要把可解释性提高,要实现这件两全其美的事情,难度比较大。其次,解释的多元主义除了怎么都行的这种形态以外,还有孤岛式的、互动式的以及整合性的形态。“这些只是同一个整体的不同侧面,AI能不能做到这样,现在其实并不是很清楚。”

推动可解释模型构建

可解释是可信AI的重要组成部分,也是可信的前提条件之一,它有很强的独特性,但并不是独立存在的概念。当前可解释AI研究思路很多,但并没有一个明确的框架,因为解释对象的不同,框架也不能统一。

香港中文大学(深圳)吴保元副教授认为,与其说AI的可解释性,还不如称之为AI的可解释力。“可解释性可能会让人们误认为这是一种性质,而可解释力就是一种可解释的能力,就如同人们常说的理解力、领导力等等,是一种手段,一种行为,一种操作的存在。”

《可解释AI发展报告2022》从科技向善的角度出发,认为需要找到一个平衡的可解释AI路径来实现可信AI,确保科技向善。张钦坤解释,简单来说就是在设计可解释性要求时,需要充分考虑可解释性要求和其他重要的伦理价值和目的,比如说公平、安全、隐私之间的平衡,因为可解释本身不是目的,而是手段。“在设计可解释AI的时候,首先需要考虑实现什么样的目标,其次才是思考在特定的情境下如何更好地匹配这些目标。”

对于AI研究里的解释性问题的基本立场,朱菁的建议是解释的多元化。“针对不同的问题,哪怕是在同一个领域里,也不能指望只有唯一的解释方式或模式,要允许多种多样的解释模型存在。”

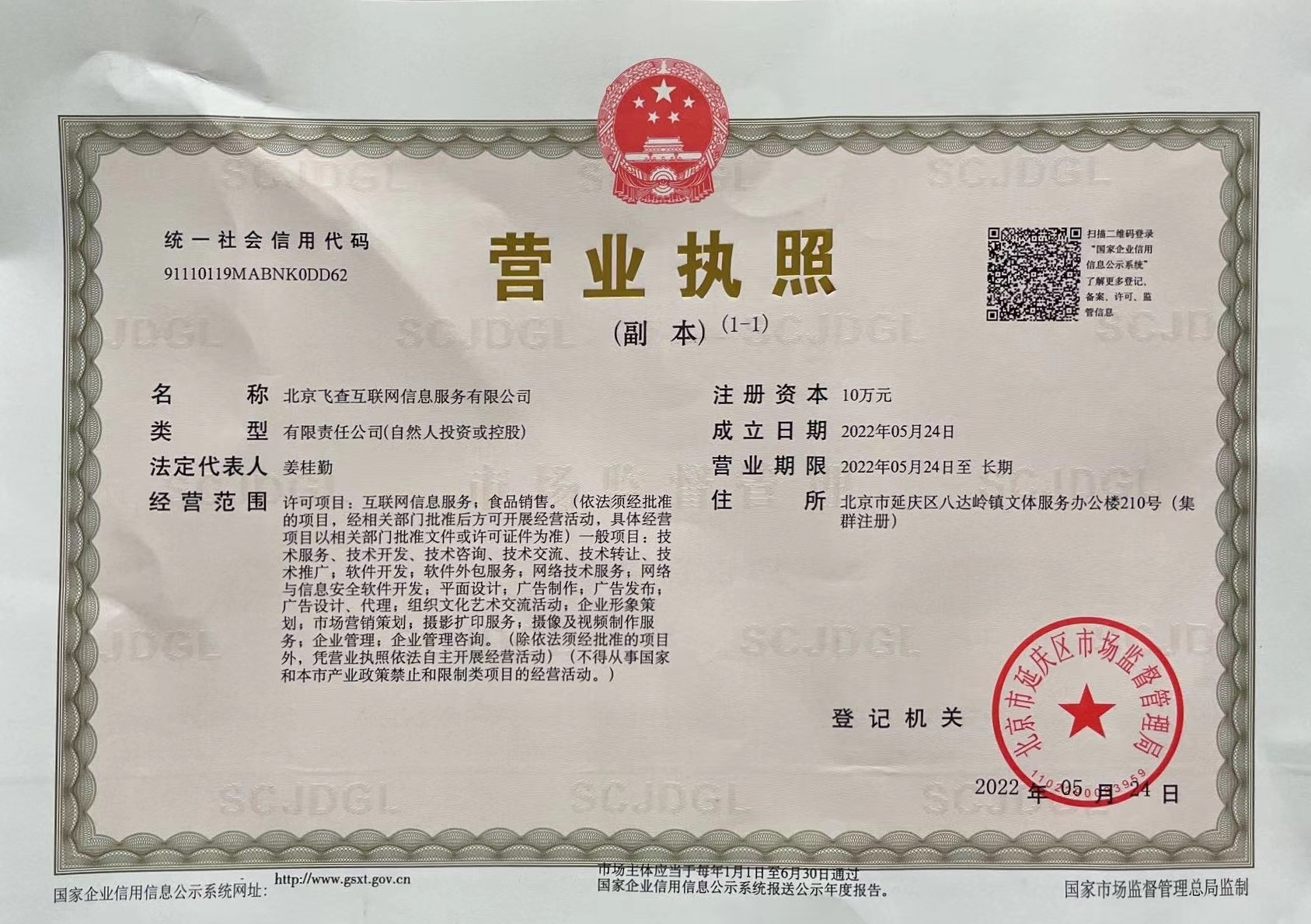

营业执照公示信息

营业执照公示信息